Was ist ein Crawler?

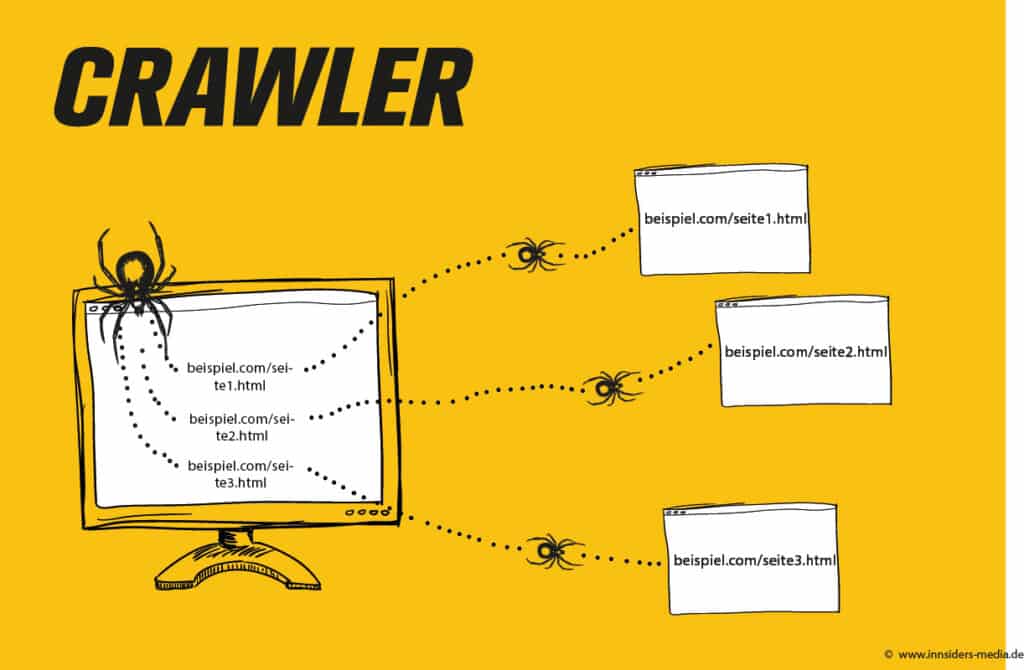

Beim Crawling durchsucht ein Programm eigenständig nach Inhalten im Internet und analysiert diese. Andere Begriffe sind Robots oder Searchbots. Über Links gelangen die Crawler an Webseiten, die auf bereits indexierten Webseiten erfasst worden sind. Crawler lesen die Inhalte, speichern sie und werden sie aus. Zuletzt werden sie je nach Status indexiert.

Google nutzt seine eigenen Crawler (sog. Googlebot), um im Internet die entsprechenden Inhalte zu finden.

Was findet ein Crawler?

Die hinter den Verlinkungen liegenden Seiten müssen unbedingt erreichbar sein, da der Crawler sich die bestehenden Verlinkungen merkt und abarbeitet. Liegen Inhalte hinter einer Login-Maske, können sie nicht erfasst werden. Diesen unsichtbaren Teil des Webs bezeichnet man als „Deep Web“.

Der Crawler hat allerdings die Möglichkeit, Ressourcen zu schonen. Dafür beendet er einfach den Prozess, wodurch die gefundenen URLS nach Wichtigkeit priorisiert werden. Außerdem muss geprüft werden, ob die Seiten bereits besucht wurden. Der Liste, die der Crawler abarbeitet, werden dann relevante URLS hinzugefügt.

Die Seiten, die als relevant eingestuft werden (beispielsweise Seiten mit vielen Verlinkungen oder mit wechselnden Inhalten), werden oft gesucht. Die Seiten, die unwichtig erscheinen, werden nicht gecrawlt. Für ersteren Fall hat jede Website ein Crawl Budget zur Verfügung. Kurz: Die Seite, die als wichtig erscheint, bekommt ein hohes Crawl Budget zugeteilt und wird öfter und intensiver gecrawlt.

Bitte nicht Crawlen!

Wenn die Seite noch nicht fertig ist, oder aus anderen Gründen von der Indexierung abgeschlossen werden soll, muss man dem Crawler dies mitteilen. Möchte man nicht, dass eine Seite gecrawled wird, legt man im Hauptverzeichnis eine Textdatei robots.txt ab oder nutzt entsprechende Meta-Tags im Kopfbereich eines HTML-Dokuments. So weiß der Crawler, dass er diese Seite nicht durchsuchen soll.

Allerdings braucht es dazu Crawler, die sich an diesen Standard halten. Ein Beispiel wäre der Googlebot. Es stellt also keine technische Hürde dar, mit der sich schädliche Bots abwehren ließen.

Brauchst du Hilfe rund um die Themen Crawling, SEO oder in anderen Bereichen des Online Marketings? Dann kontaktiere uns jetzt unverbindlich!

Ähnliche Einträge